L’intelligenza artificiale salverà il giornalismo?

L’intelligenza artificiale sta rivoluzionando il modo in cui cerchiamo, leggiamo e produciamo notizie. Una trasformazione che potrebbe rappresentare un’opportunità, oppure infliggere un nuovo colpo al giornalismo.

Negli ultimi giorni si sta discutendo molto delle nuove funzionalità introdotte dai motori di ricerca, che sostituiscono il tradizionale elenco di link con sintesi generate dall’intelligenza artificiale. Google, leader del settore da anni, ha introdotto le cosiddette AI Overview (o riassunti automatizzati) che offrono risposte già strutturate e spesso sufficientemente complete da ridurre drasticamente la necessità per l’utente di visitare le fonti originali (i siti web da cui l’IA ha preso le informazioni). Di conseguenza, molti di questi siti web stanno registrando un significativo calo di traffico organico, sollevando preoccupazioni sul futuro dell’ecosistema dell’informazione online e sulla redistribuzione del valore tra piattaforme e produttori di contenuti.

Mi è capitato di leggere diversi articoli, qualcuno anche molto ottimista, che ipotizza che l’IA stia offrendo una grande opportunità nel settore delle news. Io ci andrei più cauto.

Uno dei punti a favore sarebbe che i siti web non dovrebbero più pensare all’ottimizzazione della SEO (Search Engine Optimization), che li spingeva a scrivere titoli e contenuti privilegiando certe parole chiave che ne aumentavano la visibilità sui motori di ricerca, a discapito dell’autorevolezza e della credibilità che, invece, diventerebbero prioritari in questo nuovo funzionamento di Google e affini.

In realtà non ci sono prove che supportino questa teoria ma, anche prendendola per buona, così come nel tempo sono cambiati gli algoritmi dei motori di ricerca, possono cambiare i criteri e le priorità assegnati alle intelligenze artificiali. E questo in base alla volontà di multinazionali americane o cinesi (i paesi che più stanno investendo nel settore), il cui fine può divergere da quello di un servizio pubblico trasparente e onesto (vedi Grok e Grokipedia di Elon Musk, fortemente personalizzate dal loro creatore a discapito dell’affidabilità nel fornire informazioni).

Facendo un passo indietro, inoltre, mi sembra che il problema di questi tempi dei titoli usati da diversi giornali e riviste non sia tanto la banalizzazione dovuta alla SEO ma il clickbaiting, cioè la scelta di titoli ambigui che possono provocare reazioni più forti in parte dei lettori, a cui però non corrispondeva il contenuto effettivo dell’articolo. In certi casi questi titoli corrispondono a vera e propria disinformazione.

C’è poi un elefante nella stanza che alcuni si ostinano a fingere di non vedere. Questi motori di ricerca stanno usando i contenuti prodotti da giornali, riviste e altri media senza un riconoscimento economico per le fonti. Se prima Google aveva creato un sistema in cui riconosceva i click ottenuti dal tuo sito, oggi che questi click vengono meno non è prevista alcuna monetizzazione, specie se l’utente si limita a consultare la risposta generata dall’IA.

Quei giornali che invece si sostengono con gli abbonamenti online funzionano proprio perché i loro contenuti (in teoria di qualità superiore) non sono accessibili a chiunque. Per logica, questi contenuti di alto livello non saranno a disposizione delle IA (a meno di accordi specifici) e quindi già qui potrebbe scricchiolare il discorso iniziale del premiare la qualità. Inoltre i giornali gratuiti, perdendo i click e quindi gli introiti che ne conseguivano, saranno più difficilmente sostenibili. Il rapido crollo dei click sui siti indicizzati da Google sta già avvenendo e si possono trovare diversi articoli sul tema (ad esempio “Google users are less likely to click on links when an AI summary appears in the results” del Pew Research Center).

I software generativi, e quindi anche i nuovi motori di ricerca, in linea teorica, hanno un grande bisogno di fonti e contenuti di alta qualità, ma i giornali più importanti al mondo si sostengono con gli abbonamenti e non hanno interesse a perdere i lettori fidelizzati per diventare fornitori di informazioni di motori di ricerca basati su IA, che non portano traffico nel sito, perdendo così anche la possibilità che gli utenti siano attirati a leggere altri tuoi articoli, soffermandosi nel sito, magari clickando pubblicità e così via. Inoltre, se questi giornali decidessero di stringere accordi per diventare fornitori di contenuti informativi per le intelligenze artificiali, perché un abbonato dovrebbe continuare a pagare invece di consultare quei contenuti gratuitamente?

In altre parole, il sistema che alimentava il giornalismo online, basato sulla visibilità, la pubblicità e/o gli abbonamenti, si sta sgretolando, e non è ancora chiaro quale modello economico possa sostituirlo.

A questo punto il nodo cruciale diventa la definizione delle regole del gioco (la trasparenza del funzionamento, l’attribuzione obbligatoria delle fonti giornalistiche nelle risposte dell’IA, i meccanismi di revenue sharing, la trasparenza sui dati e le fonti con cui viene addestrata l’IA, la responsabilità per gli errori fattuali, la protezione della diversità, ecc) ma, considerando lo sbilanciamento delle forze coinvolte, sarebbe necessario un intervento collettivo, comprendendo anche i governi dei vari paesi, per sciogliere il nodo della proprietà delle informazioni e di come queste vanno remunerate dalle piattaforme di IA che le sfruttano.

Questo però rischia di diventare un desiderio irrealizzabile. Chi potrà alzare la voce con colossi tech che godono dell’appoggio dei leader di USA e Cina e che possono dettare le regole in un mondo in competizione che, per ora, non ha interesse a limitare lo sviluppo e il funzionamento dell’IA per non perdere la corsa internazionale che si sta svolgendo. Un intervento del genere sembra, allo stato attuale, fuori portata.

Nei prossimi mesi le visite ai siti e gli introiti di chi produce contenuti online continueranno a diminuire e questi potrebbero non sopravvivere abbastanza a lungo per vedere compiersi una lunga, complessa e non scontata trattativa dignitosa con le Big Tech.

Se poi le Big Tech decidessero di stringere accordi economici soltanto con alcuni produttori di notizie, cosa ne sarà della pluralità e delle piccole realtà?

Un esempio emblematico di questa dinamica è rappresentato dagli accordi di licenza stipulati tra OpenAI e il gruppo tedesco Axel Springer (editore di Politico, Bild e Die Welt) annunciati alla fine del 2023. Si tratta di uno dei primi esperimenti concreti di revenue sharing tra un colosso dell’intelligenza artificiale e un grande gruppo editoriale. In pratica OpenAI può utilizzare i contenuti giornalistici di Springer per addestrare e alimentare i propri modelli linguistici, citandone le fonti e riconoscendo un compenso economico.

Questo, tuttavia, non sembra essere un modello facilmente replicabile. Al contrario, accentua la disuguaglianza strutturale nel panorama dell’informazione perché solo pochi grandi editori, con una forza contrattuale sufficiente e un portafoglio di testate di rilevanza internazionale, possono negoziare intese dirette con le piattaforme di IA. Le realtà minori come i quotidiani locali, le riviste indipendenti, i blog d’inchiesta, le piccole testate culturali, ecc rischiano di restare invece escluse da qualunque forma di remunerazione, pur contribuendo in modo significativo al pluralismo informativo e alla qualità del dibattito pubblico.

La soluzione non è evitare il cambiamento, ma evitare che questo avvenga quando in campo ci sono forze palesemente asimmetriche, con quelle più forti che possono deformare il funzionamento del mondo dell'informazione.

Per salvare il giornalismo occorre prima salvare le condizioni che permettono al giornalismo di esistere. Fra queste vi è la giusta retribuzione per chi produce conoscenza.

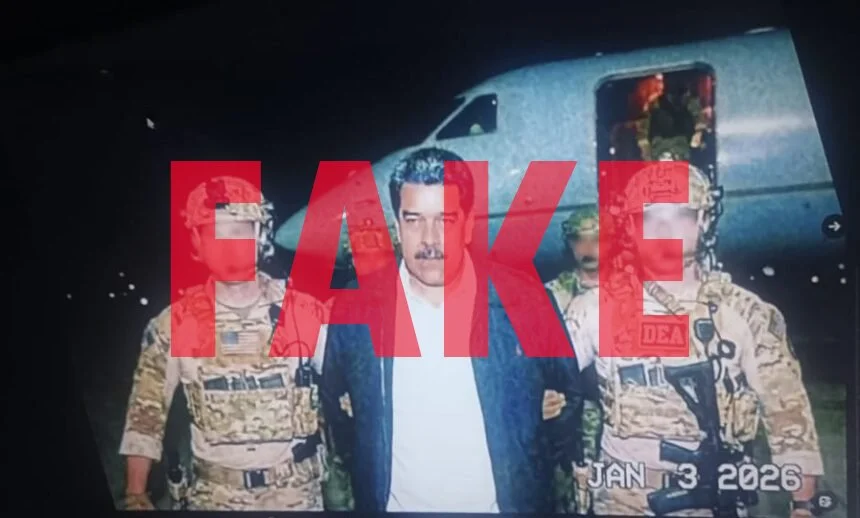

[l’immagine di apertura proviene dal mio progetto Broken Mirror, realizzato con l’intelligenza artificiale]