(in italiano sotto)

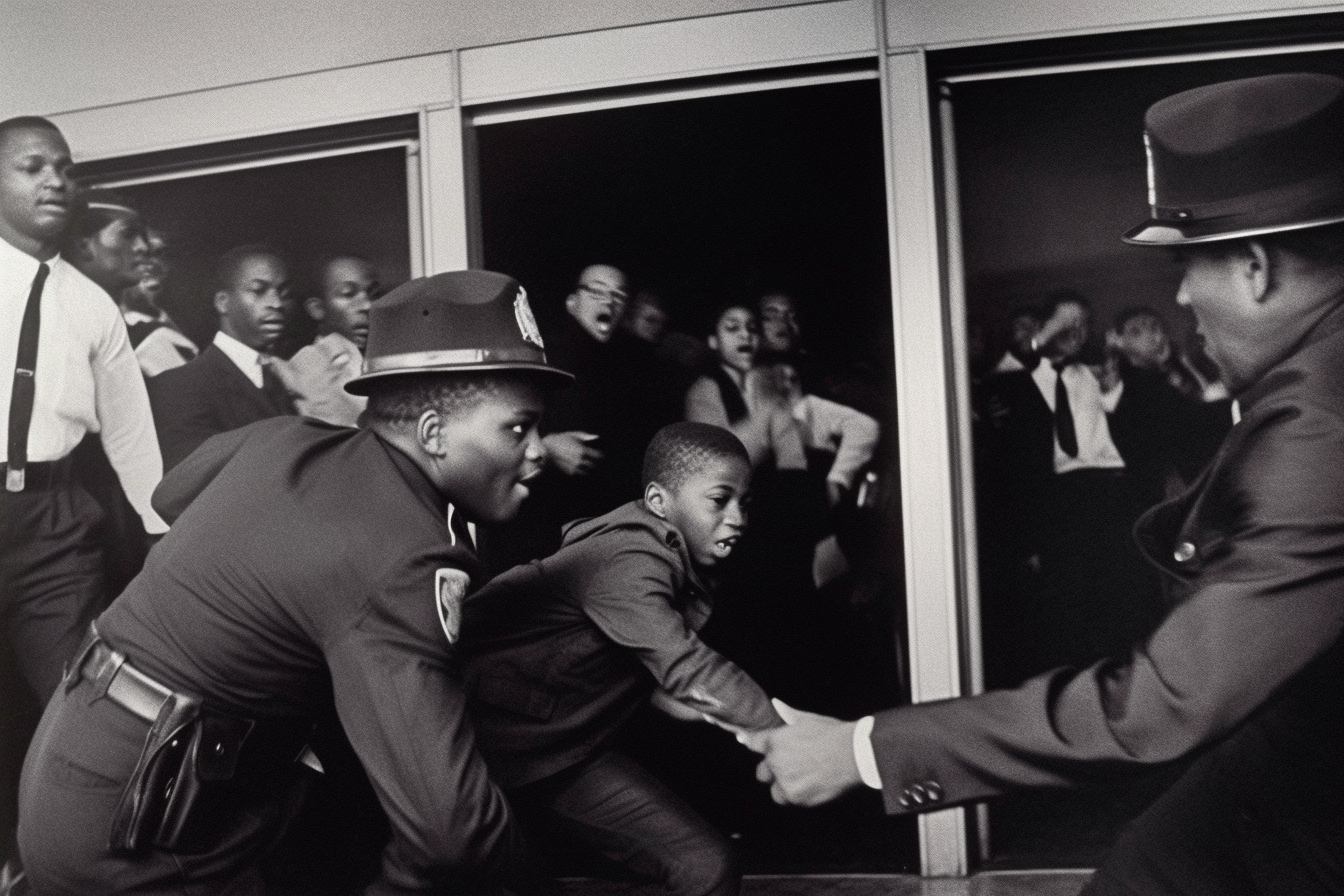

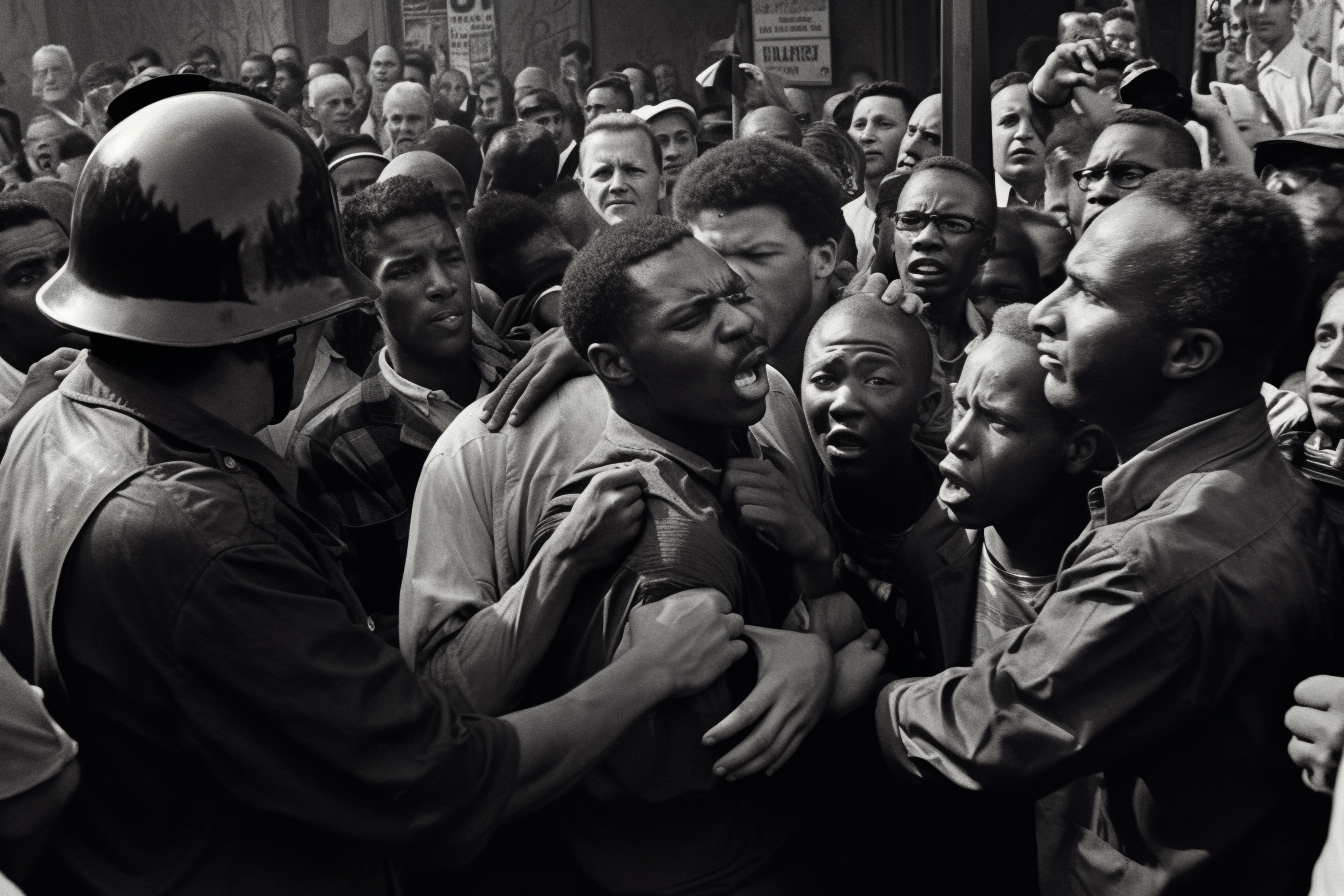

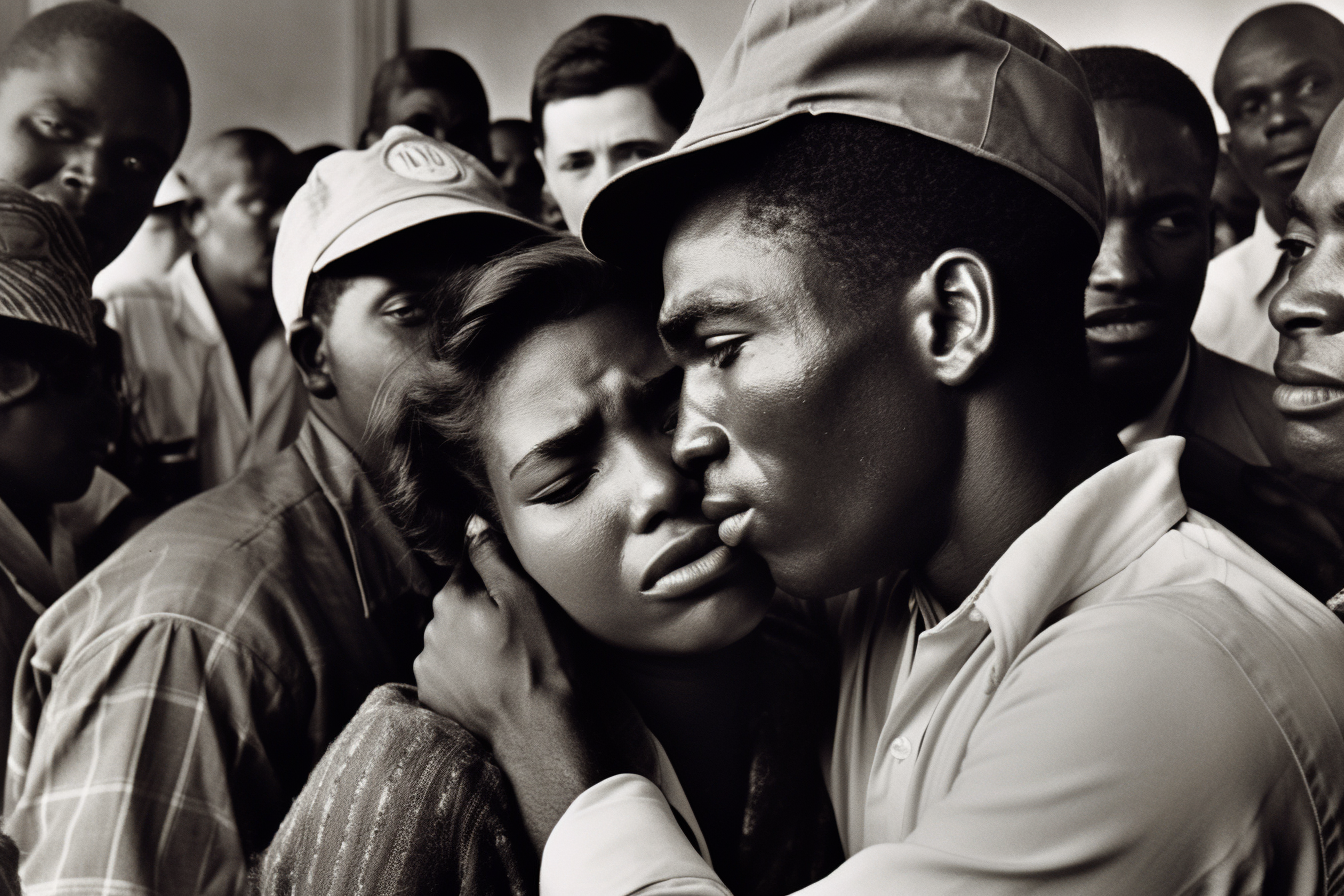

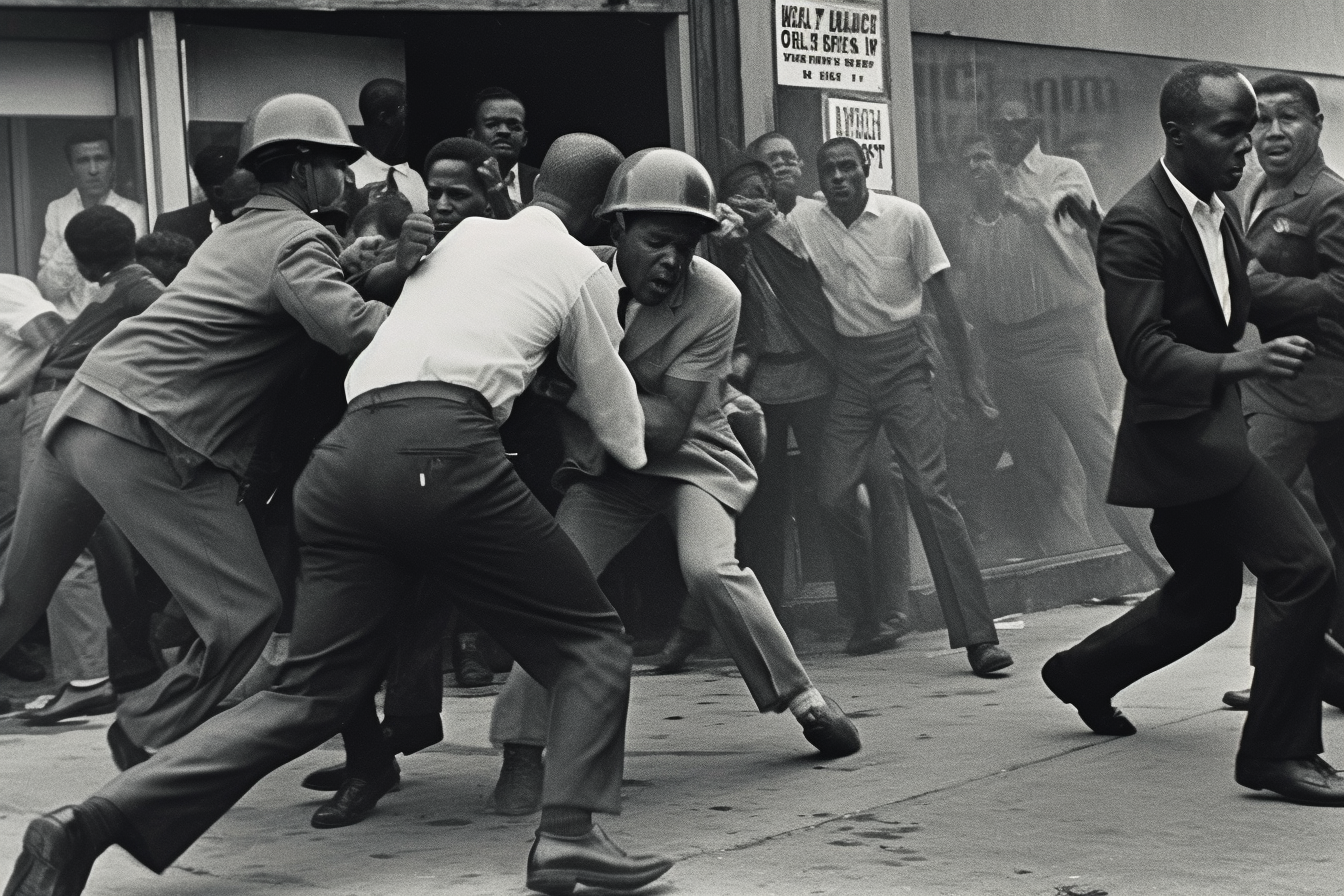

AI and Prejudice

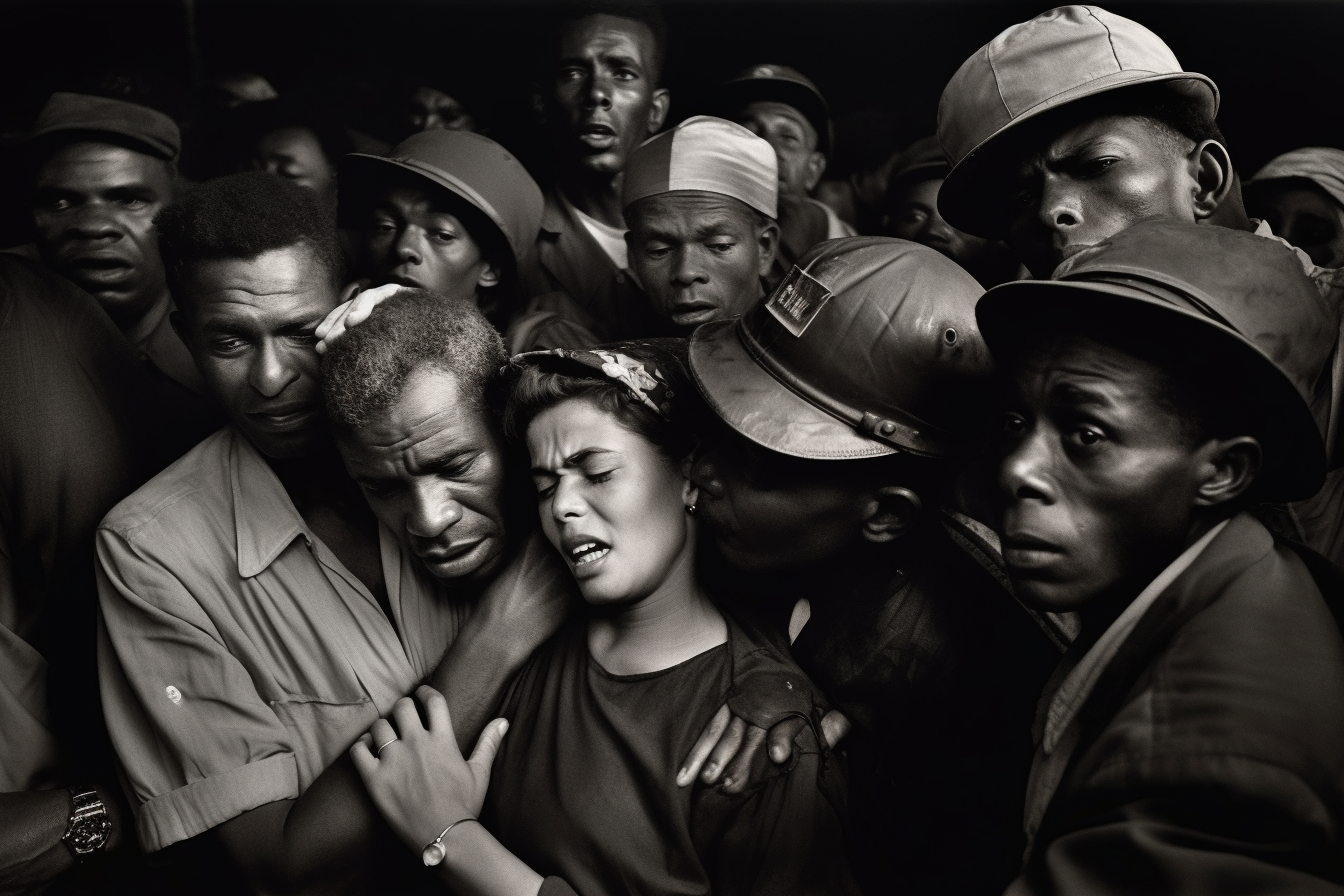

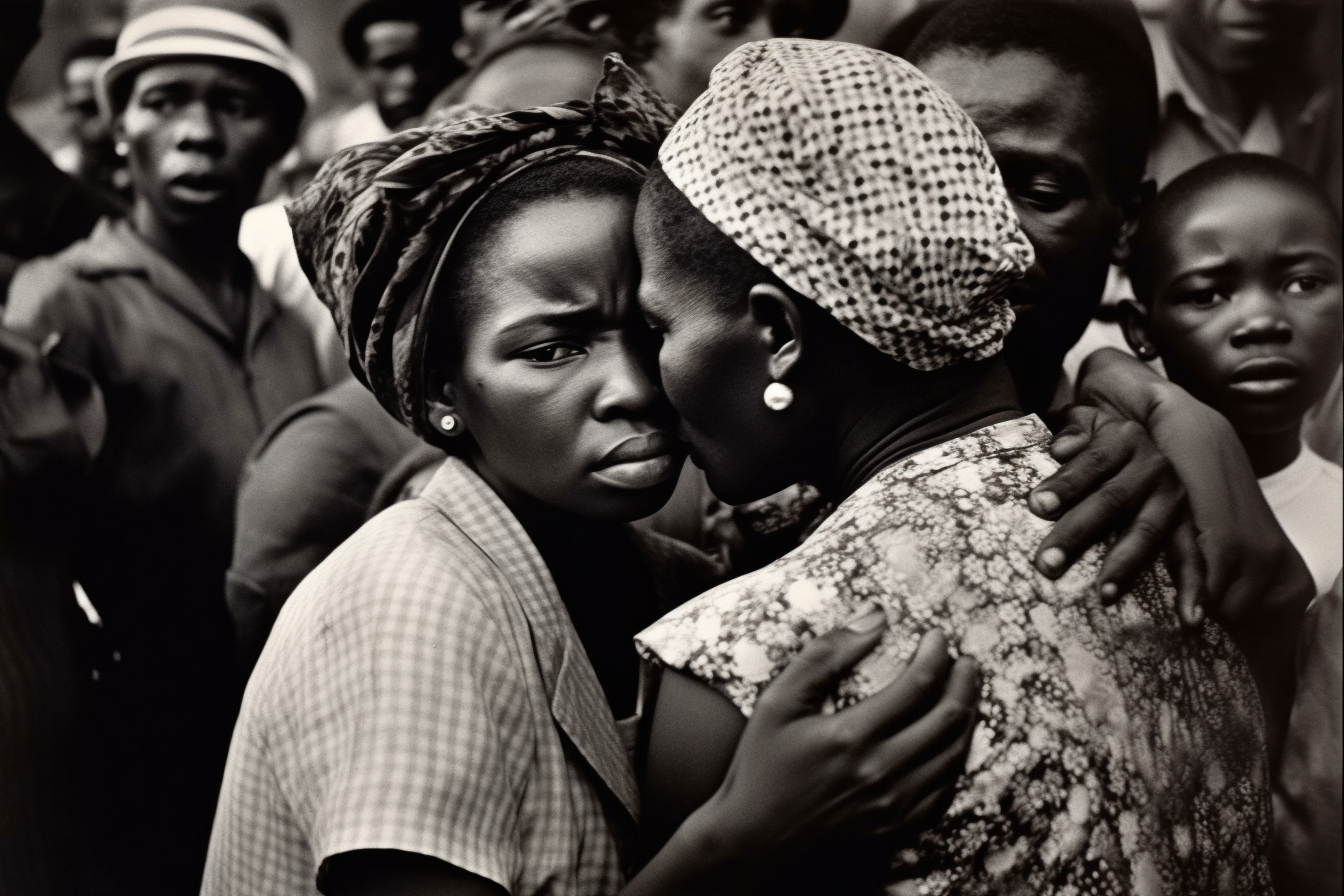

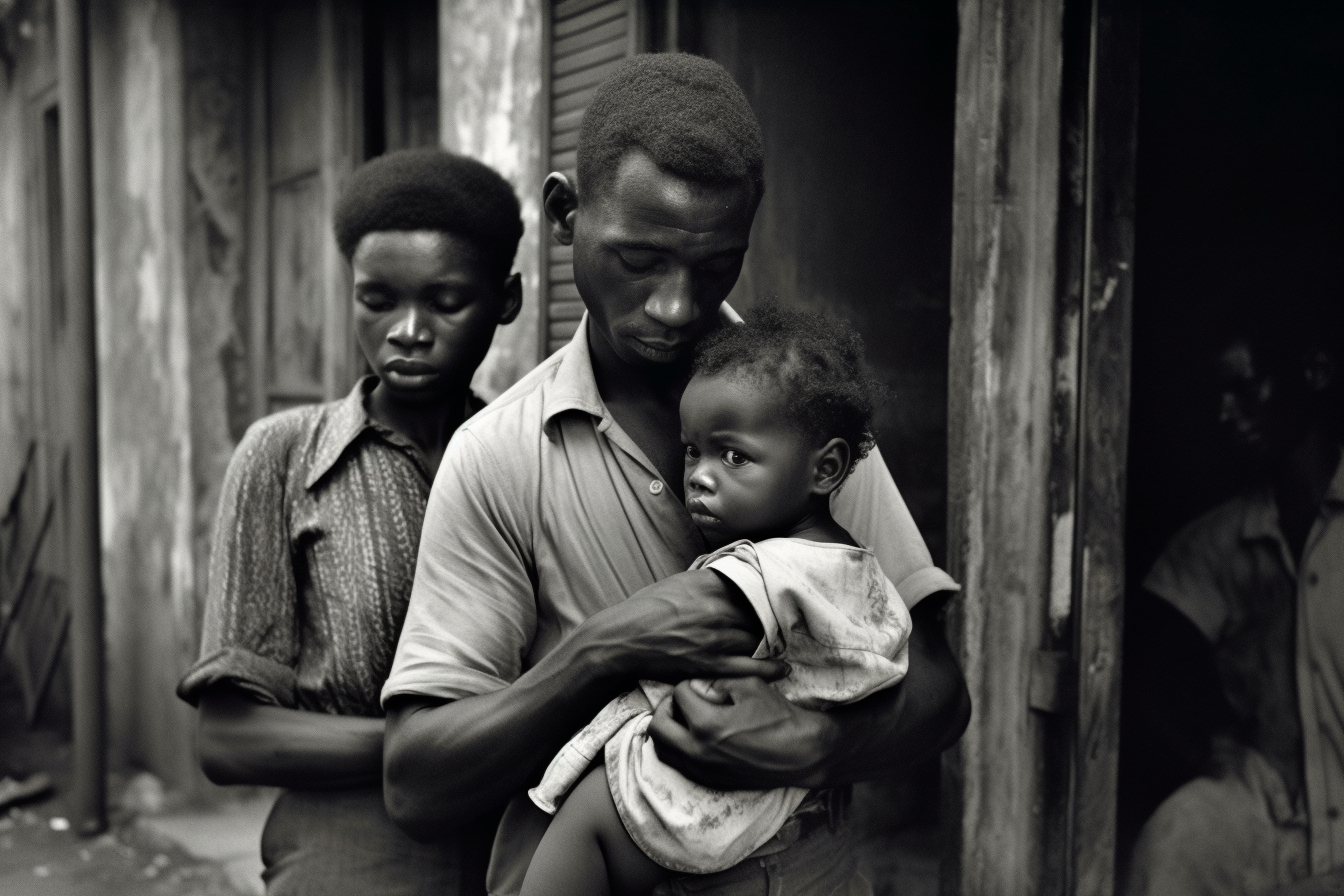

(Images generated with artificial intelligence, 2023)

An article published on 8 February 2023 by The Guardian, highlighted how the algorithms used by artificial intelligence tend to be gender biased and end up censoring photographs depicting women's bodies, especially when nipples are visible, or pregnant women or women exercising. Large technology companies, including Google, Microsoft and Amazon, which are at the forefront of the development of software using artificial intelligence, have implemented filters to protect their users from seeing unwanted, violent or pornographic images. For example, it has been known for several years that some social networks censor female nipples but not male ones.

Journalists from the British newspaper tested this software using artificial intelligence in analysing hundreds of photographs of men and women in their underwear, while exercising, or using medical tests with partial nudity, and found that artificial intelligence labels photographs of women in everyday situations as sexually allusive. This software tends to rate pictures of women as more racy or sexually allusive than similar pictures of men. Among other consequences, social networks that make use of these algorithms censor or suppress (in the sense of making less visible to users) countless images depicting women's bodies, in some cases even harming women-led companies and businesses, further amplifying social inequalities.

Even photographs for medical use are affected by this problem. Testing these artificial intelligence algorithms on images released by the US National Cancer Institute, in particular one showing how to perform a clinical breast examination, it emerged that Google's artificial intelligence had assigned a high score in terms of indecency, Microsoft's artificial intelligence was 82% sure that the image was 'explicitly sexual', while Amazon's artificial intelligence classified it as representing 'explicit nudity'. Even photographs of pregnant women, where the belly is visible, are problematic in this regard. Google's artificial intelligence classified such a photo as 'very likely to contain racy content', while Microsoft's was 90% sure that the image was 'sexually allusive'.

Behind this problem, there is a phenomenon known to those in the field, namely that of the so-called 'biases' (prejudices/distortions), which are present in today's society and which end up inside the databases (archives) that are provided to artificial intelligence software to train itself. These archives are often a mirror of reality, where gender inequality, for example, leads artificial intelligence to imagine a man when it comes to power roles or a woman when it comes to domestic work.

Artificial intelligence bias can therefore influence the representation of women and their identities, enclosing them within predefined roles and, in a way, repeating and reiterating those limitations that have influenced women's lives for centuries and which, with difficulty, are being dismantled.

AI e Pregiudizio

(Immagini generate con intelligenza artificiale, 2023)

Una indagine pubblicata l'8 febbraio 2023 da The Guardian, ha evidenziato come gli algoritmi utilizzati dalle intelligenze artificiali tendano ad avere pregiudizi di genere, finendo col censurare le fotografie che raffigurano corpi di donne, soprattutto quando in queste sono visibili i capezzoli, oppure donne incinta o che praticano esercizio fisico. Le grandi aziende tecnologiche, fra cui Google, Microsoft e Amazon, che sono all'avanguardia nello sviluppo di software che sfruttano l'intelligenza artificiale, hanno implementato dei filtri allo scopo di proteggere i propri utenti dal vedere immagini indesiderate, violente o pornografiche. Già da diversi anni è noto, ad esempio, come alcuni social network censurino i capezzoli femminili ma non quelli maschili.

I giornalisti del giornale inglese hanno testato questi software che utilizzano l’intelligenza artificiale nell’analizzare centinaia di fotografie di uomini e donne in biancheria intima, mentre facevano esercizio fisico, oppure utilizzando test medici con nudità parziale e hanno scoperto che l’intelligenza artificiale etichetta le fotografie delle donne in situazioni quotidiane come sessualmente allusive. Questi software tendono a valutare le immagini delle donne come più audaci o sessualmente allusive rispetto a immagini simili raffiguranti gli uomini. Fra le varie conseguenze, c’è quella che vede i social network che fanno uso di questi algoritmi censurare o sopprimere (nel senso di rendere meno visibili agli utenti) innumerevoli immagini raffiguranti corpi di donne, in alcuni casi anche danneggiando le aziende e le attività guidate da donne, amplificando ulteriormente le disparità sociali.

Anche le fotografie per uso medico sono toccate da questo problema. Testando questi algoritmi di intelligenza artificiale sulle immagini rilasciate dal National Cancer Institute degli Stati Uniti, in particolare una in cui viene mostrato come eseguire un esame clinico del seno, è emerso come l'intelligenza artificiale di Google avesse assegnato un punteggio elevato in termini di indecenza, quella di Microsoft era sicura all'82% che l’immagine fosse "esplicitamente di natura sessuale", mentre quella di Amazon l’ha classificata come rappresentante "nudità esplicita". Persino le fotografie di donne incinta, dove è visibile la pancia, sono problematiche da questo punto di vista. L’intelligenza artificiale di Google ha classificato una foto di questo tipo come “molto probabile che contenga contenuti audaci”, mentre quella di Microsoft era sicura al 90% che l'immagine fosse "di natura sessualmente allusiva".

Dietro questo problema, c’è un fenomeno noto agli addetti al settore, cioè quello dei cosiddetti “bias” (pregiudizi/distorsioni), che sono presenti nella società attuale e che finiscono dentro i database (archivi) che vengono forniti ai software di intelligenza artificiale per allenarsi. Questi archivi spesso sono uno specchio della realtà, dove la disparità di genere ad esempio spinge l’intelligenza artificiale ad immaginare un uomo quando si parla di ruoli di potere oppure una donna quando si parla di lavori domestici.

I bias dell'intelligenza artificiale possono quindi influenzare la rappresentazione delle donne e delle loro identità, chiudendole all’interno di ruoli predefiniti e, in qualche modo, ripetendo e ribadendo quelle limitazioni che da secoli influenzano la vita delle donne e che, a fatica, si sta cercando di smantellare.